Беседа вторая. Кому он может понадобиться?

Беседа вторая. Кому он может понадобиться?

Кто? Где? Когда?

"Из интервью, которое специальный корреспондент Хармонтского радио взял у доктора Валентина Пильмана по случаю присуждения последнему Нобелевской премии по физике за 19... год.

- Вероятно, вашим первым серьезным открытием, доктор Пильман, следует считать так называемый радиант Пильмана!

- Полагаю, что нет. Радиант Пильмана - это не первое, не серьезное и, собственно, не открытие. И совсем не мое.

- Вы, вероятно, шутите, доктор. Радиант Пильмана - понятие, известное всякому школьнику.

- Это меня не удивляет. Радиант Пильмана и был открыт впервые именно школьником. К сожалению, я не помню, как его звали. Посмотрите у Стетсона в его "Истории Посещения" - там все это подробно рассказано. Открыл радиант впервые школьник, опубликовал координаты впервые студент, а назвали радиант почему-то моим именем.

- Да, с открытиями происходят иногда удивительные вещи. Не могли бы вы объяснить нашим слушателям, доктор Пильман...

Кто? Где? Когда?

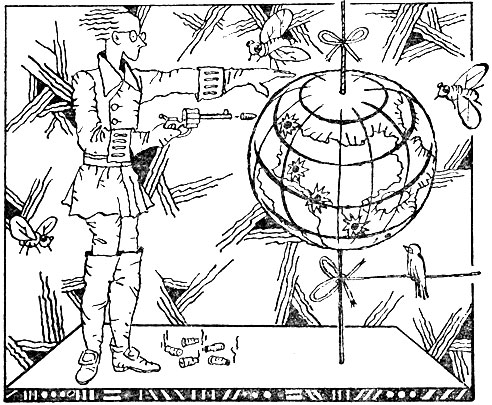

- Послушайте, земляк. Радиант Пильмана - это совсем простая штука. Представьте себе, что вы раскрутили большой глобус и принялись палить в него из револьвера. Дырки на глобусе лягут на некую плавную кривую. Вся суть того, что вы называете моим первым серьезным открытием, заключается в простом факте: все шесть Зон Посещения располагаются на поверхности нашей планеты так, словно кто-то дал по Земле шесть выстрелов из пистолета, расположенного где-то на линии Земля - Денеб. Денеб - это альфа созвездия Лебедя, а точка на небесном своде, из которой, так сказать, стреляли, и называется радиантом Пильмана".

Почему мы начали свою вторую беседу отрывком из повести А. и Б. Стругацких "Пикник на обочине"? По двум причинам. Во-первых, ситуация, похожая на описанную у Стругацких, имела место при становлении общей теории связи, которая - ныне это общепризнано - представляет собой важную составную часть кибернетики. Во-вторых, и в том и в другом случае все началось со стрельбы.

'Пикник на обочине'

Н. Винер, по его собственным словам, занялся теорией информации, решая задачу о стрельбе из зенитных орудий по самолетам. В той же "Кибернетике", в первой главе, он пишет: "Чтобы подойти к технике связи с этой стороны, нам пришлось разработать статистическую теорию количества информации. В этой теории За единицу количества информации принимается количество информации, передаваемое при одном выборе между равновероятными альтернативами. Такая мысль возникла почти одновременно у нескольких авторов, в том числе у статистика Р. А. Фишера, у д-ра Шеннона из Белловских телефонных лабораторий и у автора настоящей книги".

Как все обстояло на самом деле? Начало исследований в данной области положили труды Р. Фишера по статистической теории информации. В 1921 году он опубликовал "Статистические методы для исследователей", где впервые обозначил подходы к тому, что теперь, во всяком случае в литературе на русском языке, принято называть общей теорией связи. В 1928 году американский инженер Р. В. Л. Хартли опубликовал статью под названием "Передача информации". Он писал:

"Говоря о пропускной способности системы передачи информации, мы молчаливо предполагаем какую-то количественную меру информации. В обычном понимании термин "информация" слишком эластичен; необходимо прежде всего установить для него специфический смысл, подразумеваемый в настоящем исследовании. С этой целью рассмотрим, с какими факторами мы имеем дело в связи, осуществляется ли она по проводу, путем устной речи, письма или каким-либо другим способом".

Пожалуй, Р. Хартли первым осознал необходимость перехода от эластичного общепринятого понятия об информации к строгому научному определению.

Раз уж мы предприняли исторический экскурс, нельзя не упомянуть работу советского ученого, ныне академика В. А. Котельникова "О пропускной способности "эфира" и проволоки в электросвязи", опубликованную в 1933 году. Почти во всех трудах по общей теории связи и теории информации ссылаются на работу Н. Винера "Экстраполяция, интерполяция и сглаживание стационарных временных рядов", опубликованную в 1949 году. Для полноты картины стоит напомнить, что работа академика А. Н. Колмогорова "Интерполирование и экстраполирование стационарных случайных последовательностей" вышла в 1941 году.

Суть, конечно, не в том, кто первым сказал "Э!". Надо разобраться в главном - что такое информация. Для этого вернемся к задаче о стрельбе по самолетам. Предположим, что точка, где находится самолет в данный момент времени, известна. Самолет виден невооруженным глазом, и с помощью угломерных инструментов можно измерить его координаты. Как правильно отметил Н. Винер, целиться в эту точку бессмысленно, потому что скорости снаряда и самолета имеют один и тот же порядок (то же самое тем более справедливо для современных ракет) и за то время, пока снаряд долетит до точки прицеливания, самолет отойдет от нее на достаточно большое расстояние. Следовательно, целиться надо не в ту точку, где самолет находится в момент выстрела, а в ту, где он окажется в момент, когда снаряд достигнет места встречи. Но как узнать координаты точки встречи?

Трудами многих ученых, среди которых значительное место занимают работы А. Колмогорова и Н. Винера, была создана теория временных рядов. Не вдаваясь в подробности, скажем, что наглядным примером временного ряда могут служить последовательные положения самолета, совершающего маневр. Теория временных рядов установила, что, зная прошлые значения членов временного ряда, можно вынести суждение о значениях будущих его членов. В нашем случае, зная прошлые положения самолета (по условию задачи они известны), можно предсказать его будущее положение.

На основании теории временных рядов или какой-нибудь другой теории мы действительно можем узнать будущее положение самолета и вести прицельную стрельбу в эту точку. Знать - это располагать информацией об исследуемом предмете. Вряд ли кто-нибудь станет спорить с таким определением. А коли так, то теория временных рядов, казалось бы, дает возможность получить определенную информацию - информацию о будущем положении самолета, - которую мы не можем получить в результате наблюдений или, скажем, с помощью интуиции.

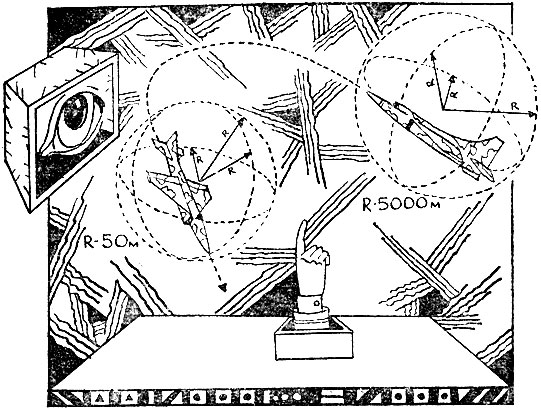

Представьте себе, что в некоторый момент времени вы наблюдаете самолет в определенной точке пространства. Скорость самолета ограничена, и, следовательно, через десять секунд он не может отлететь от этой точки на расстояние, большее чем пять километров. Нам неизвестно, какое направление дальнейшего полета выберет летчик, тем не менее мы можем утверждать, что через десять секунд самолет заведомо окажется где-то внутри шара радиусом пять километров. Как видите, что-то все-таки можно предсказать, не пользуясь ничем, в том числе и теорией временных рядов, а зная лишь, как говорят, тактико-технические данные современных самолетов. Добавим, что для прицельной стрельбы достаточно знать проекцию этого шара на плоскость предполагаемой траектории полета снаряда. Такое знание называется априорным: наблюдая самолет в данной точке и зная его предельную скорость, вы одновременно знаете радиус некоторой окружности, внутри которой он находится.

Проведем вычисления на основании теории временных рядов. Как бы аккуратно их ни проделывать, вы в результате не узнаете точки, в которой самолет будет находиться через десять секунд. Вы снова узнаете лишь радиус окружности, в пределах которой он будет находиться. За количество информации, полученной в процессе вычислений, предлагается принять отношение радиуса окружности, о котором вы знали до вычислений, к радиусу окружности, полученному в результате вычислений.

Неважно, кто первый предложил такую меру количества информации - Н. Винер или другой американский ученый - К. Шеннон. На первый взгляд правомочность использования такой меры не вызывает сомнений. Не проведя вычислений, вы знали, что самолет будет находиться где-то внутри круга радиусом пять километров. Проведя вычисления, вы знаете, что самолет будет находиться опять-таки внутри круга, но радиусом, скажем, пятьдесят метров. Произошло несомненное уточнение будущего положения самолета. А раз произошло уточнение, значит, ясно, что вы получили информацию и тем ее больше, чем точнее вы знаете будущее положение самолета.

Строго говоря, за меру количества информации предлагалось принимать не саму величину отношения, а величину логарифма от этого отношения, но об этом речь впереди. Добавим, что стрелять даже не зенитным снарядом, а современной ракетой класса земля-воздух куда-то в центр круга радиусом в пять километров бессмысленно. Только по счастливой случайности удастся поразить самолет. Иное дело стрелять в центр круга радиусом пятьдесят метров. Если самолет находится в пределах этого круга, а ракета имеет современную боеголовку, цель будет поражена наверняка. Так что предложенная мера количества информации имеет явно выраженный прагматический смысл. Казалось бы, на этом можно поставить точку и задним числом поздравить авторов столь удачного определения количества информации. Но подождем, как говорится, радоваться.

Спортлото

Проницательный читатель наверняка заметил, что почти во всех названиях перечисленных работ фигурирует слово "статистический". А это означает, что на основании теории временных рядов или любой другой подобной ей теории можно предсказать будущее положение самолета не абсолютно точно, но с определенной вероятностью. Сколь-либо подробное обсуждение существа и возможностей теории вероятностей не входит в наши задачи. Мы ограничимся только одним примером.

Некто сохраняет все таблицы тиражей спортлото. В один прекрасный день он раскладывает перед собой эти таблицы и проводит исследование. Его интересует, сколько раз за все время существования спортлото выпадала, скажем, цифра семь. Ясно, что рассмотрение одной таблицы ответа на этот вопрос не даст. Не даст ответа и изучение десяти или ста таблиц. Вот если таблиц окажется очень много, наш пытливый исследователь получит возможность убедиться, что цифра семь выпадает в среднем один раз на каждые сорок девять таблиц. Это и есть основной вывод теории вероятностей. Согласно строгому определению вероятностью выпадения семерки (или любой другой цифры) называется предел отношения числа таблиц, содержащих семерку, к общему числу таблиц при условии, что это общее число таблиц стремится к бесконечности.

Следовательно, теория информации дает нам возможность утверждать, что в игре в спортлото любая загаданная цифра, например семерка, встречается в среднем один раз на сорок девять таблиц. Та же самая теория вероятностей утверждает и следующее. Это утверждение мы приводим специально для тех, кто пытается предсказать выигрышную комбинацию на основе анализа предыдущих таблиц. Если, скажем, состоялось пятьдесят тиражей подряд и в них ни разу не встретилась семерка, то вопреки всем ожиданиям это обстоятельство нисколько не увеличивает вероятность выпадения семерки в следующем, пятьдесят первом тираже. Она по-прежнему остается равной одной сорок девятой. В справедливости этого утверждения каждый из уважаемых читателей может убедиться лично. Вероятность того, что семерка не выпадет в двух тиражах подряд, выражается довольно большой величиной. Тем не менее просмотр тех же таблиц показывает, что такое в общем встречается и не столь уж редко.

Теперь мы сформулируем основной вопрос. Предположим, что обнаружен самолет в данной точке, проведены необходимые вычисления, нацелено зенитное орудие туда, куда его нужно нацеливать в соответствии с вычислениями, и произведен выстрел. Можно ли быть уверенным, что вражеский самолет поражен? Увы, ни в коем случае! Самолет или будет поражен, или нет. К нашему великому сожалению, это единственное, что можно сказать. Независимо от того, равна вероятность поражения 0,6, или 0,9, или 0,99, ответ на вопрос одинаковый. С одного выстрела самолет или будет поражен, или нет - и добавить к этому нечего. Так же, как в игре в орлянку, если вы знаете, что монета вопреки всем ожиданиям сто раз подряд выпадала орлом (предполагается, что монета "правильная"), то о результатах сто первого бросания можно сказать только одно: монета выпадет или орлом, или решкой.

Какова же тогда ценность временных рядов и основанных на них методов предсказаний? Зачем оборудуют зенитные орудия дорогостоящими вычислительными устройствами, работающими на основе теории временных рядов или других статистических теорий?

Ответ достаточно прост, и он имеет принципиальное значение для всего, о чем мы собираемся говорить. Поэтому мы просим уважаемого читателя как следует обдумать вместе с нами то, что сейчас будет сказано.

Никто никогда не станет стрелять по вражескому самолету одним снарядом. Более того, почти во всех случаях поражение одного-единственного самолета, даже если он на самом деле будет поражен, не окажет существенного влияния на исход сражения.

Задача, которая ставится перед зенитной артиллерией, формулируется так: поразить наибольшее количество самолетов, затратив при этом наименьшее количество снарядов. Для решения подобной задачи статистические методы имеют поистине огромную ценность.

Здесь в точности та же ситуация, что и при изучении таблиц спортлото. Если таблиц достаточно много, то количество встретившихся там семерок близко к одной сорок девятой от числа таблиц, и тем ближе, чем таблиц больше. Если предсказание местоположения самолета производится с вероятностью, скажем, 0,6, то из тысячи выпущенных снарядов около шестисот попадут в цель. Это предсказание будет все более точным по мере увеличения числа снарядов и числа самолетов.

Теория вероятностей, а точнее, основанный на ней аппарат математической статистики представляет собой мощнейшее средство исследования массовых процессов. Средство тем более весомое, что для весьма точных и далеко идущих предсказаний подчас требуется относительно немного исходных данных. Но речь идет именно о массовых процессах, в которых участвуют очень большие количества объектов.

Вернемся к тому, с чего начался этот разговор. Мы наблюдали самолет в некотором ряде его прошлых положений. На основании обработки данных наблюдений с применением некоторой статистической теории сделано предсказание будущего положения самолета. Можно ли сказать, что мы знаем будущее положение самолета, то есть имеем информацию о будущем его положении? Иными словами, можно ли считать, что мы знаем о местоположении самолета, если на вопрос: находится ли самолет в пределах круга данного радиуса или нет? - ответ будет или "да", или "нет". Повлияет ли он на то, что мы называем знанием, другая формулировка ответа: самолет будет находиться в пределах круга данного радиуса с вероятностью 0,6?

Пусть каждый из читателей постарается сам для себя ответить на поставленный здесь вопрос. Что касается авторов, то мы твердо убеждены в следующем. Знание вероятности наступления некоторого события представляет собой знание. Только это не знание о самом событии как таковом, а знание того, сколько раз может наступить это событие, если условия для его наступления создаются достаточно много раз подряд.

Любые выводы, основанные на вероятностях, нельзя считать информацией о событии. А количественную меру, построенную на вероятности, нельзя считать мерой информации.

Не скроем, подобное мнение противоречит установившейся на сегодня точке зрения большинства ученых на теорию информации. Поэтому нам представляется важным проследить тот исторический путь, в результате которого сформировался вероятностный подход к информационным процессам.

Точка зрения президента

В 1876 году президент США Гарфилд весьма категорично высказался по поводу телефона:

- Как открытие оно исключительное, но только кто им будет пользоваться?

Вопреки мнению президента телеграфная, телефонная, а в дальнейшем и радиосвязь развивалась чрезвычайно быстрыми темпами и со временем неотъемлемой составной частью вошла в промышленные комплексы и государственный аппарат многих стран. Стало ясно, что связь, тем более на далекие расстояния, достаточно дорогое удовольствие. Возникла насущная необходимость проектировать системы связи на строгой научной основе.

Точка зрения президента

Общепризнанным основоположником современной общей теории связи, которую в большинстве случаев считают также и теорией информации, является американский ученый К. Шеннон. К. Шеннон занимался исследованием конкретного процесса - процесса передачи сигналов по телеграфным и телефонным каналам. Ход его рассуждений был примерно таким. По телеграфному каналу передаются сообщения, представляющие собой последовательности букв какого-нибудь алфавита, например латинского. При желании можно составить следующую таблицу соответствий: а - 00000, в - 00001, с -00010, d - 00011, в - 00100 и т. д. Последовательность из пяти символов, каждый из которых может быть либо нулем, либо единицей, имеет 32 различные конфигурации. Этого достаточно, чтобы поставить по одной из них в соответствие каждой букве латинского алфавита (их всего 26), а также некоторым самым важным знакам препинания.

Пусть символу 1 соответствует некоторое положительное электрическое напряжение в цепи телеграфного канала, а символу 0 - такое же по абсолютной величине, но отрицательное электрическое напряжение. Факт установления в телеграфной цепи напряжения данного знака называется посылкой. Каждая посылка соответствует одному символу: либо 1 (положительное напряжение), либо 0 (отрицательное напряжение). Длительность посылки определяется свойствами телеграфного канала и не может быть меньше некоторой величины τ. Шеннон считал все посылки одинаковой длительности, равной τ.

В подобных условиях передача одной буквы латинского алфавита занимает время, равное 5τ. Для передачи двух букв требуется 5·2·τ и в общем случае для передачи n букв - 5nτ единиц времени. Нельзя ли передать сообщение, представляющее собой последовательность n букв латинского алфавита, по данному каналу связи за время, меньшее, чем 5nτ? Такую задачу поставил перед собой и пытался решить К. Шеннон.

Оказалось, это задача разрешимая, если сообщения представляют собой слова какого-то языка или последовательности слов. Разрешима она потому, что разные буквы в любом языке встречаются не одинаково часто. Например, в тексте на русском языке длиной, скажем, в тысячу букв буква "о" встречается примерно 90 раз, буква "р" - 40 раз, а буква "ф" - 2 раза. Аналогичные закономерности справедливы для английского и других языков. В чем заключалась основная идея Шеннона?

Для чаще встречающихся букв использовать меньшее число посылок. Например, чаще всего встречающуюся в английских текстах букву "е" представлять одной посылкой, а букву "а" - двумя и т. д.

Сразу выяснилось, что подобная таблица соответствий была составлена задолго до работы К. Шеннона и называется она азбукой Морзе. В азбуке Морзе все так и делается: буква "е" представляется одной точкой (при желании и мы можем считать символ 1 точкой, а символ 0 тире), буква "а" - точкой и тире (в нашем случае комбинаций 10) и т. д.

Таким образом, теория Шеннона подтвердила эффективность азбуки Морзе, построенной исходя из интуитивных соображений.

Следующий шаг К. Шеннона состоял в том, что он подсчитал среднее количество посылок, приходящееся на букву. Как он это сделал? Взял количество посылок, потребное для передачи буквы "а", прибавил к нему количество посылок, потребное для передачи буквы "в", и так до конца алфавита; затем прибавил количество посылок, потребное для передачи точки, запятой, других знаков препинания, и полученную сумму разделил на 32. Вычислил величину, называемую арифметическим средним для совокупности из 32 чисел.

Мы подробно разбираем такой, казалось бы, элементарный вопрос, потому, что он имеет для нас принципиальное значение. Среднее количество посылок, приходящихся на букву русского алфавита, при условии, что передаются слова, фразы и тексты на русском языке, равно примерно 4,35. Эта величина представляет собой среднее арифметическое от числа посылок, требующихся для передачи букв русского алфавита, при условии, что частоты, с которыми эти буквы встречаются, характерны для русского языка.

К. Шеннон назвал эту величину средним количеством информации, приходящейся на символ. Для использования слова "информация" здесь не было никаких оснований. Речь шла о предельно ясной вещи: количестве посылок - количестве случаев, когда напряжение в телеграфной цепи либо положительное, либо отрицательное.

Слово "информация" К. Шеннон использовал, по всей видимости, потому, что не предвидел всех вытекающих отсюда последствий. Не менее важно и другое обстоятельство. Повсюду в работах К. Шеннона речь идет не о количестве информации вообще, а о среднем количестве информации, приходящейся на одну букву.

Стремимся вдаль

Математики любят, построив какую-нибудь формальную конструкцию, посмотреть, что с ней произойдет на бесконечности. Любовь эта небескорыстная. Часто оказывается, что трудности, возникающие при попытках решения тех или иных задач, отпадают при предельном переходе.

Не избежал этого соблазна и К. Шеннон. Он решил посмотреть, что произойдет с его мерой при предельном переходе к бесконечности. Средняя частота, с которой встречается тот или иной символ, это количество раз, когда данный символ встречается в строке, состоящей, скажем, из тысячи символов. Поделите это количество раз на длину строки, в нашем случае на тысячу, получите величину, которая и называется относительной частотой в отличие от просто частоты.

Предел, к которому стремится относительная частота при неограниченном увеличении длины строки, есть не что иное, как вероятность встретить символ в тексте, написанном на каком-либо языке.

Вычислив предел относительных частот, с которыми встречаются символы алфавита, К. Шеннон определил среднее количество информации, приходящееся на один символ. Среднее количество информации, приходящееся на символ, оказалось обратно пропорциональным вероятности, с которой данный символ встречается в тексте.

Пока речь идет об одной-единственной задаче: как передать по каналу связи некоторое сообщение за минимальное время? С учетом огромного числа различных каналов связи в мире и их загруженности даже ничтожное сокращение затрат на передачу одного сообщения сулило грандиозный, как теперь говорят, экономический эффект. Так вот, учет частоты, с которой встречаются различные буквы английского алфавита, а теперь мы скажем - учет вероятностей, с которыми встречаются эти буквы, - позволяет уменьшить среднее количество посылок на символ приблизительно на 12 процентов. Это огромная величина. К. Шеннон стал бы мультимиллионером, если бы до него соответствующие методы уже не были предложены Морзе.

Все ли возможности исчерпаны учетом вероятностей появления отдельных букв?

Конечно, не все. Двухбуквенные сочетания также встречаются с различными вероятностями. Каждый знающий английский язык хорошо представляет себе, что сочетания "th" или "оu" встречаются чаще, чем другие. Дальнейший выигрыш был получен с учетом вероятности двухбуквенных, трехбуквенных и так далее сочетаний. Снова возникает интересная подробность. Вероятность, с которой встречается некая пара произвольно выбранных из алфавита букв (без учета особенностей языка), равна произведению вероятностей появления каждой буквы. Произведению, а не сумме.

Не правда ли, знакомая нам ситуация? Среднее количество информации, приходящееся на сочетание из двух символов, равно произведению средних количеств информации, приходящихся на каждый символ. Это, что ни говори, неудобно. К. Шеннону не оставалось ничего другого, как пойти по пути, уже проторенному Р. Хартли: использовать не сами вероятности, а логарифмы этих вероятностей. В результате получилась знаменитая мера количества информации Шеннона.

Чтобы окончательно оправдать свой предельный переход, К. Шеннон ввел в рассмотрение стационарный стохастический источник, то есть гипотетическое устройство, которое в каждый момент времени из набора символов с некоторой заданной вероятностью выбирает один символ. Что означает слово "стационарный" в нашем случае?

Вероятности появления каждого символа не меняются во времени. Требование к стационарности совершенно необходимо. Сама по себе вероятность - это предел отношения количества случаев, когда встречается данный символ, к длине строки символов при условии, что длина строки стремится к бесконечности. А стремление длины строки к бесконечности означает, что время передачи t стремится к бесконечности.

Если допустить, что вероятность меняется со временем, понятие вероятности теряет смысл. Это весьма важное обстоятельство изощренные математики научились обходить с помощью так называемой эргодической гипотезы (конечно, в тех случаях, когда она справедлива), а большинство специалистов его просто забывают, что приводит к досадным недоразумениям.

Чтобы все стало совсем ясно, давайте рассмотрим такой пример. Пусть имеется строка текста, содержащая миллион символов. Пусть буква "а" встречается в этой строке 500 тысяч раз. Поделив пятьсот тысяч на миллион, мы получим величину 0,5, которая представляет собой среднюю частоту, с которой в рассматриваемом тексте встречается буква "а". С учетом всех оговорок мы можем считать также величину 0,5 вероятностью появления буквы "а" в данном тексте.

Стремимся вдаль

Далее поступаем согласно К. Шеннону. Берем двоичный логарифм от величины 0,5 и называем то, что получилось, количеством информации, которую переносит одна-единственная буква "а" в рассматриваемом тексте.

Продолжаем анализ дальше. Пусть буква "б" встречается в том же самом тексте 250 тысяч раз. Делим 250 тысяч на миллион и получаем, что средняя частота (вероятность), с которой в данном тексте встречается буква "б", равна 0,25. Снова берем двоичный логарифм от величины 0,25 и получаем величину, равную количеству информации (по Шеннону), которое в данном тексте сопровождает появление каждый буквы "б". Такую же точно операцию мы проделываем далее для букв "в", "г", "д" и т. д.

Теперь теория К. Шеннона предлагает нам вычислить среднее количество информации, приходящееся на один символ. Для того чтобы вычислить среднее для какого-то количества чисел, мы должны сначала сложить между собой все эти числа, а полученную сумму разделить на общее количество чисел. Сейчас мы это и проделаем, но применим одну хитрость.

Сначала сложим все числа, равные количеству информации, переносимой буквой "а". Полученную сумму сразу разделим на количество, как говорят, вхождений буквы "а" в изучаемый текст. Здесь мы применяем хорошо известное не только в математике, но и в литературе правило: от перестановки слагаемых сумма не меняется.

Затем складываем между собой числа, равные количеству информации, переносимой буквой "б". Делим полученную сумму на количество вхождений буквы "б" и т. д. Просим читателя подумать и убедиться, что мы действительно вычислили самое настоящее среднее. Просто при суммировании мы брали буквы не в том порядке, в каком они входят в текст, а сначала взяли все буквы "а", потом все буквы "б" и т. д. Интересно заметить, что точно так же поступают опытные кассиры, когда подсчитывают мелочь. Сначала сортируют монетки, а потом подсчитывают количество пятачков, трехкопеечных монет и т. д.

Итак, вместо того чтобы сначала просуммировать все количества информации, беря слагаемые в том порядке, в каком встречаются буквы в тексте, а затем разделить полученную сумму на общее количество букв, мы сначала суммируем все числа, относящиеся к букве "а", и делим сумму на общее число букв "а" в тексте, затем поступаем так же с буквой "б" и т. д. А затем складываем между собой полученные промежуточные результаты.

Обратите внимание на то, что единица, деленная на число вхождений, скажем, буквы "а", и есть не что иное, как частота или в нашем случае вероятность встретить букву "а" в данном тексте. Значит, логарифм от средней частоты, с которой встречается буква "а", да еще поделенной на общее число вхождений буквы "а", представляет собой произведение вероятности вхождения буквы "а" на двоичный логарифм этой вероятности.

Общий итог вычислений, равный по Шеннону средней информации на символ, представляет собой сумму членов вида: вероятность, помноженная на логарифм этой же самой вероятности, - причем общее число суммируемых членов равно общему числу букв в исследуемом тексте.

А теперь самое интересное. На памятнике немецкому ученому Л. Больцману (1844-1906) высечена формула, выведенная им в 1877 году и связывающая вероятность состояния физической системы и величину энтропии этой системы. Мы не станем сейчас разбираться в смысле терминов: вероятность, состояние и энтропия. Скажем только, что энтропия - это термодинамическая величина, описывающая состояние нагретого тела, и что относительно этой самой энтропии выведен один из законов - так называемое второе начало термодинамики, - претендующий на роль одного из фундаментальных законов природы.

Так вот, формула, высеченная на памятнике Л. Больцмана, абсолютно совпадает с формулой, предложенной К. Шенноном для среднего количества информации, приходящейся на один символ. Совпадение это произвело столь сильное впечатление, что даже количество информации стали называть энтропией.

Теория, предложенная К. Шенноном, упала на исключительно благоприятную почву. В это время, то есть в 40-х годах нашего века, теория вероятностей совершала триумфальное шествие по разным отраслям знаний. Еще в конце XIX века завершилось построение термодинамики. К 30-м годам была окончательно сформулирована квантовая механика, в которой понятие о вероятности состояния занимает одно из центральных мест. И вот теперь - теория связи. Соображения, развитые К. Шенноном, позволили решить много практических задач и, в частности, чрезвычайно важную задачу выделения сигнала на уровне шумов. Применяя шенноновские методы, можно не только обнаруживать, но и исправлять отдельные ошибки, встречающиеся в передаваемых текстах. Справедливости ради скажем, что то же самое мы умеем делать и чисто интуитивно. Например, увидев в конце телеграммы слово "цекую", мы, не задумываясь, читаем его как "целую", не используя при этом никаких теорий.

В чем состояло основное достижение шенноновской теории? С ее помощью была доказана общая возможность выделения сигнала из смеси его с шумом даже в тех случаях, когда мощность шума во много раз превосходит мощность сигнала. Это дало сильный толчок развитию радиолокации, радиоастрономии и других областей науки и техники.

Н. Винер включил шенноновскую теорию информации как составную часть своей кибернетики.

Долой неопределенность!

Средний логарифм вероятностей, или, иначе, величина, называемая энтропией, обладает примечательным свойством. Она принимает максимальное значение, когда все вероятности одинаковы или - применительно к термодинамическим системам, - когда все состояния системы равновероятны. Это послужило поводом для следующей трактовки шенноновской меры количества информации. Рассуждали примерно так.

Система, все состояния которой равновероятны, характеризуется наибольшей степенью неопределенности. Если все состояния равновероятны, нет никаких оснований выделить одно какое-то состояние, предпочесть его другим. Отсюда вывод: чем больше энтропия системы, тем больше степень ее неопределенности. Поступающее сообщение полностью или частично снимает эту неопределенность. Следовательно, количество информации можно измерять тем, насколько понизилась энтропия системы после поступления сообщения. За меру количества информации принимается та же энтропия, но взятая с обратным знаком.

Тут-то и вскрылась самая уязвимая точка шенноновской теории. В чем же дело? Пусть имеются две системы, характеризуемые в данный момент разными значениями энтропии, то есть разной степенью неопределенности. Обе системы получают одно и то же сообщение. Но энтропия их изменяется от полученного сообщения по-разному, в зависимости от их начального состояния. Значит, количество информации в сообщении зависит не от самого сообщения, а от того, кто его получает. Ясно, что в таких условиях не может быть построена никакая самосогласованная физическая теория.

Обычно высказанные соображения иллюстрируют следующим примером. Получено сообщение о том, что температура воздуха равна +20° С. Вероятность такого значения температуры в наших широтах велика летом и очень мала зимой. В полном соответствии с теорией Шеннона делается вывод, что одно и то же сообщение летом содержит меньше информации, а зимой больше.

Поразительно, что многие воспринимают подобные вещи как нечто само собой разумеющееся. Им даже в голову не приходит, что коли так, то следует создавать не одну, а по меньшей мере две разные теории информации. Одну - зимнюю, другую - летнюю. Подобные рассуждения о температуре эквивалентны тому, как если бы мы считали, что гвоздь является гвоздем только для того, кому он нужен, а для того, кому он не нужен, он вовсе даже и не гвоздь.

Каждый последовательный физик понимает, что если результат измерения температуры несет какую-либо информацию, то количество этой информации зависит от того, насколько тщательно проведены измерения, от точности измерительного прибора, может быть, от других каких-либо условий, но ни в коем случае не от того, кто или что является получателем сообщения о величине температуры.

На этом неприятности не закончились. Мера Шеннона в принципе не накладывает ограничений на количество информации. Вероятность некоторого события может быть сколь угодно близка к единице, и, следовательно, количество информации по Шеннону может быть сколь угодно близко к нулю. Наоборот, вероятность некоторого события может быть сколь угодно близка к нулю, и, естественно, количество информации по Шеннону может быть сколь угодно близко к бесконечности. Но какое действие на реальную физическую систему произведет сообщение, содержащее исчезающее малое количество информации? Иметь дело с физическими величинами, способными обращаться в бесконечность, также крайне неудобно. Бесконечность делится на любое количество частей, и каждая из них все равно остается бесконечностью.

Примечательно, что с подобными трудностями столкнулся сам К. Шеннон. Попытавшись определить количество информации в непрерывно изменяющемся сигнале, он сразу получил бесконечность. А ведь непрерывно изменяющийся сигнал - это то, что передает в эфир любая радиостанция. Чтобы выйти из этого затруднения, К. Шеннону пришлось ввести в рассмотрение некоторую малую величину - квант количества информации.

С аналогичной задачей за сорок с лишним лет до К. Шеннона столкнулся Макс Планк. Он изучал ситуацию, в которой величина, в его случае энергия излучения нагретого тела, обращалась в бесконечность. В качестве математического аппарата для описания ситуации использовалась энтропия. В чем состоял выход, предложенный М. Планком? Не считать излучение непрерывным, а ввести в рассмотрение некую порцию - квант излучения, - тот самый квант, который затем лег в основу квантовой физики. Так стоило ли через сорок лет начинать все сначала?

Применительно к термодинамической энтропии трудами крупнейших физиков второй половины XIX века Р. Клаузиуса (1822-1888), Л. Больцмана и Дж. Гиббса (1839-1903) удалось сформулировать весьма общий закон природы, получивший название закона неубывания энтропии, или второго начала термодинамики. Согласно этому закону энтропия замкнутой физической системы может только либо оставаться постоянной, либо возрастать. Пожалуй, сейчас уместно еще раз предоставить слово Н. Винеру.

"Мы сказали, что количество информации, будучи отрицательным логарифмом величины, которую можно рассматривать как вероятность, по существу есть некоторая отрицательная энтропия. Интересно отметить, что эта величина в среднем имеет свойства, которые мы приписываем энтропии... Как и следовало ожидать, процессы, ведущие к потере информации, весьма сходны с процессами, ведущими к увеличению энтропии".

Н. Винер хотел сказать здесь, что с течением времени отдельные тексты могут повторяться все чаще и чаще, что сопровождается, очевидно, увеличением вероятности вхождения каждого символа. Другие тексты, наоборот, постепенно забываются (либо буквально, либо вследствие того, что в каналах связи действуют помехи, искажающие отдельные символы). Это снова приводит к изменению вероятности.

Никакое действие над сообщением не может при этом дать увеличения средней информации. Здесь мы имеем точное применение второго закона термодинамики к технике связи. Наоборот, большее уточнение неопределенной ситуации дает в среднем увеличение информации и никогда не приводит к потере информации.

Ничто с такой убедительностью не заставляет нас поверить в справедливость некой научной гипотезы, как сознание, что где-то в другой отрасли науки подобное уже встречалось. Так произошло со знаменитой планетарной моделью атома Резерфорда, наибольшая привлекательность которой состояла в том, что она напоминала Солнечную систему. То же самое получилось и с энтропией. С тех пор как обнаружилось, что количество информации, приходящееся на один символ, по Шеннону, и энтропия термодинамической системы описываются одинаковыми математическими формулами, слово "энтропия" стало чуть ли не синонимом слова "информация". Иногда при этом говорили, правда, о негэнтропии, то есть об энтропии с обратным знаком.

Похоже, что мы чересчур углубились в серьезные материи. Пора дать читателю немножко отдохнуть, а заодно признаться в том, что наряду с рассказами об информатике, истории ее зарождения и современным состоянием мы хотели бы вспомнить несколько имен ученых, незаслуженно забытых. Приведем сейчас отрывок из статьи, написанной в свое время одним из авторов для журнала "Знание - сила".

Лед на Днепре

Осенью 1951 года автор этих строк отправился в командировку в Киев. Цель - принять работы, выполнявшиеся Институтом физики АН УССР. В кармане - весьма внушительный мандат, "тактико-технические требования, безапелляционно устанавливающие, какова должна быть амплитуда импульсов на выходе устройства, какими должны быть частота и форма этих импульсов и сколько часов должно работать устройство без единой неисправности или сбоя, и командировочное удостоверение, отводящее на все про все двое суток. Хоть у меня в те времена не было даже высшего образования, амбиция явно не соответствовала ни возрасту, ни положению. Явившись в институт, я немедленно потребовал (именно потребовал) себе рабочее место и комплект необходимой аппаратуры и, уединившись в маленькой комнатке, начал добросовестно измерять амплитуды и частоты. Не знаю, как бы мне удалось справиться с пунктом ТТТ, устанавливающим количество часов бесперебойной работы - оно намного превышало время, отведенное на командировку, - но тут за моей спиной послышались шаги.

Обернувшись, я увидел высокого, очень стройного и очень элегантного человека. Левая рука на бедре придерживает полу расстегнутого пиджака, между пальцами дымящийся "Казбек". Правая рука в постоянном движении. Тонкие выразительные губы изогнуты легкой саркастической усмешкой. Чем-то он напоминал известную фотографию Оскара Уайльда, правда, без черной визитки, белых перчаток и брильянтовой булавки в галстуке.

- Молодой человек, - сказал он мне тоном, сразу открывающим опытного лектора, - очков мы не втираем. Давайте лучше сядем рядом, и я расскажу сам, что у нас получилось, а что нет.

Так состоялась наша первая встреча с Александром Александровичем Харкевичем. Вечером того же дня мы сидели за столиком в грязноватом зале ресторана "Театральный". Для меня до сих пор остается тайной, почему член-корреспондент АН УССР, профессор, руководитель отдела технической физики принял приглашение нахального мальчишки - инженера без высшего образования, но эту первую беседу я буду помнить всю жизнь.

Собственно, я не могу даже сказать сейчас, о чем мы тогда говорили. Разговор перескакивал с современных проблем физики полупроводников на стихи Теофиля Готье, с молодой, только рождающейся в те времена вычислительной техники на общие вопросы организации научных исследований. Ясно одно - после беседы с Александром Александровичем я понял совершенно отчетливо, что существует большая наука, что больше всего на свете мне хочется приобщиться к этой науке и что важнейший этап на пути к осуществлению этой мечты - осознать всю глубину собственного невежества. Улетая на другой день в Москву, я увозил с собой книжку английского писателя Найджела Белчина "В маленькой лаборатории". Давая мне эту книжку, Александр Александрович сказал, что, по его мнению, очень важно научиться с пользой тратить время в поездах, самолетах и других видах транспорта.

В Киеве я начал бывать довольно часто. Помнится мне семинар в Институте физики. Полутемный зал, похожий на зал провинциального клуба. В зале серьезные "взрослые" люди. На эстраде - Александр Александрович, освещенный софитами. Сопровождая слова четкими движениями руки, держащей мел, Александр Александрович объясняет принцип действия авиационного радиовысотомера. В зале недоумение. Наконец кто-то очень солидный не выдерживает:

- Помилуйте, Александр Александрович, к чему это? Мы все прекрасно знаем принцип действия альтиметра с пилообразной частотной модуляцией!

- Ах знаете. Ну что ж, это значительно облегчает мою задачу. В таком случае возьмем преобразование Фурье от посылаемого и принимаемого сигналов.

Несколько секунд - и доска оказывается заполненной новыми выкладками.

- Теперь подсчитаем разностный спектр... Очевидно, что этот спектр есть тождественный нуль. Следовательно, разностного сигнала не существует, а следовательно, не существует и радиовысотомера, который мог бы работать по такому принципу.

- Но помилуйте...

Аудитория достаточно квалифицированная, и через несколько минут ни у кого не остается сомнений, что математика безупречна. Но ведь альтиметр-то существует уже несколько лет и честно работает почти на всех современных самолетах. Значит, здесь просто неприменимы методы спектрального анализа. Так рождалась новая теория, которая была затем изложена в монографии А. Харкевича "Спектры и анализ".

Еще один семинар, на сей раз в лаборатории. Небольшая комната набита битком. Многие стоят. Я позволяю себе высказать сомнение: сходится ли только что написанный Александром Александровичем интеграл? Все лица повернулись ко мне. Удивление, почти суеверный ужас, гнев. Чувство такое, что еще немного, и меня буквально вынесут на кулаках. Подумать только, усомнился в математической культуре шефа!

Очередная командировка в Киев. На этот раз срок командировки двадцать четыре часа "от подъезда до подъезда моей организации". Цель - принять и привезти в Москву аппаратуру, созданную в лаборатории Александра Александровича. Ранним мартовским утром директорская "Победа" везет меня во Внуково. За ночь нападало много снега, и "Победа" летит как глиссер между снежными валами. Подъезжаем прямо к трапу. После короткого сна в воздухе снова "Победа", киевское такси. Коридор Института физики. Открываю одну знакомую дверь - пусто, открываю другую знакомую дверь - то же самое. До обратного самолета у меня несколько часов. Стараясь унять нервы, открываю теперь уже незнакомые двери - пусто. Наконец в конце коридора появляется старушка уборщица.

- Где люди-то, бабуся?

- Людей тебе, милок? А люди все на Днепр поехали, смотрят, как лед взрывают.

Опять такси, Я весь еще под впечатлением бешеной езды - полета по Внуковскому шоссе.

- Александр Александрович, ну как же так? Я же послал телеграмму!

И снова, как в нашу первую встречу, губы Александра Александровича изгибаются в ироническую улыбку.

Не знаю, что подумает, прочитав этот короткий эпизод, заместитель директора по кадрам одного из наших НИИ. Но как мало, как чудовищно мало среди наших инженеров, кандидатов и докторов технических наук людей, способных полчаса простоять на улице, наблюдая за работой нового снегоочистителя, людей, способных починить телевизор или транзисторный радиоприемник, людей, способных не только водить, но и исправить автомобиль.

Аппаратуру я привез вовремя, но она не была использована в окончательном варианте проекта. Скажу больше - она не отвечала пресловутым ТТТ. А вот метод записи нескольких дорожек на узкой магнитной ленте, предложенный тогда Александром Александровичем, используется сейчас не только в устройствах магнитной записи вычислительных машин, но и в любом магнитофоне. Широкое распространение, правда только в специальной аппаратуре, получила и магнитомодуляционная головка, позволяющая считывать информацию с медленно движущегося или даже неподвижного носителя.

Александр Александрович Харкевич родился 3 февраля 1904 года в Петербурге. Через годы и города пронес он облик истинного ленинградца: спокойствие, элегантность, тонкая ирония. В 1930 году Александр Александрович закончил Ленинградский электротехнический институт имени В. И. Ульянова (Ленина).

20-е и 30-е годы - время бурного развития радио. Активно действует в нашей стране Общество друзей радио. Повсюду можно встретить небольшие брошюрки с черной рамкой на обложке и буквами ОДР. К слову сказать, одна из таких брошюрок была написана инженером Лосевым, на два десятилетия предвосхитившим идею транзисторов.

Приемник может сделать каждый из любых подсобных материалов. Катушки мотаются "звонковым" проводом на картонных коробках из-под кофе. Если ты сторонник микроминиатюризации, можешь мотать катушку на спичечном коробке. Конденсаторы делаются из конфетных станиолевых оберток. Самая тонкая деталь - детектор - изготовляется в пробирке путем нагревания смеси свинца и серы. Несколько взрывов на кухне, обожженные пальцы, экскурсия на крышу для установки антенны, и границы мира для тебя больше не существуют. Ночи теперь проводятся только с наушниками на голове.

Сегодня невольно испытываешь сожаление - настолько наглядной была тогдашняя радиотехника. Святая святых - электронная лампа проглядывалась насквозь. Сквозь стекло, покрытое золотисто-черным налетом, можно было видеть все ее детали, а обладая известным воображением, даже электроны, летящие от вишнево-красной нити накала через сетку к аноду. У тогдашних радиолюбителей, проводивших ночи за отыскиванием чувствительной точки кристалла, вырабатывалась изумительная способность чувствовать новые идеи кончиками пальцев. А в идеях недостатка не было. Детекторные приемники, ламповые приемники, супергетеродины. Движущиеся модели, управляемые по радио. Громкоговорящий прием.

Нет ничего удивительного в том, что после поступления в институт в 1922 году Александру Александровичу стало тесно в учебных аудиториях. Уже в 1924 году он - монтер в аккумуляторной лаборатории, затем практикант, техник и руководитель работ на заводе. Учеба не заброшена, но одновременно с усвоением математики, физики, электротехники отрабатываются способности блестящего экспериментатора, уменье думать не только головой, но и руками. В эти годы у Александра Александровича выработалось поражавшее всех, кто его знал, умение мыслить геометрическими образами и, наоборот, видеть "вещное" в самых абстрактных математических и физических теориях.

Лед на Днепре

Радиотехника тех лет не то чтобы проста, но уж очень лежала на поверхности. Отмотаешь виток - изменилась индуктивность катушки. Нужно увеличить емкость конденсатора - добавь еще полоску станиоля. Иное дело громкоговорители. Здесь приходится иметь дело не с "плоскими" схемами, а с трехмерным объемом воздуха, в котором распространяются звуковые волны. Объем воздуха взаимодействует с поверхностью рупора. Возникают сложные резонансные явления. Существовавшая в те времена теория могла дать только самое приближенное представление о процессах рождения и распространения звуковых колебаний.

И вот в 1928 году выходит в свет первая статья А. Харкевича "Экспериментальное исследование некоторых свойств репродукторов". Институт еще не закончен, но ученый уже родился. Всю свою дальнейшую жизнь Александр Александрович будет избегать легких путей и простых решений. Всегда самые актуальные вопросы и всегда немного впереди.

В 1938 году Александр Александрович доктор технических наук, профессор, крупнейший специалист в области теоретической и прикладной акустики. За первой статьей последовали "Опыт расчета рупорного электродинамического громкоговорителя" (1930), "К вопросу о новой системе электромагнитных громкоговорителей" (1932), монографии "Электроакустическая аппаратура" (1933), "Примеры технических расчетов в области акустики" (1938) и "Теория электроакустических аппаратов" (1940).

Но не надо думать, что все эти годы Александр Александрович интересовался только акустикой. Его вторая в жизни научная статья называется "О детектировании биений" (1930), а в 1931 году выходит работа "Электромеханические аналогии". Одним из замечательных качеств Александра Александровича как ученого была его способность видеть аналогии между самыми непохожими на первый взгляд явлениями природы. В 1952 году вышла его небольшая книжка "Автоколебания". В ней с единых позиций и без применения математики описывается, а точнее, объясняется работа поршневых двигателей, пневматических ударных инструментов, инерционного маятника часов, термопрерывателя, электронных параметрических генераторов и электронных генераторов сверхвысоких частот, исследуются явления автоколебаний резца токарного станка, явления флаттера и шимми у самолетов, образования звука гармонным язычком в органной трубе.

Нет. не зря любил Александр Александрович смотреть, как взрывают лед на Днепре, и ходил туда не только сам, но приглашал с собой весь свой отдел. А что касается токарного станка, то в кабинете ученого всегда стоял один, а подчас и два токарных станка. Работал на них Александр Александрович искусно и с увлечением.

Конечно, найдутся люди, которые будут говорить, что ученый "разбрасывался", что подобная широта интересов приводит к верхоглядству. Но в том-то и дело, что Александр Александрович совсем не разбрасывался. Он умел видеть то общее, что объединяет разнородные на первый взгляд явления. Работа поршневого двигателя, часов и лампового электронного генератора, а также многих других систем, как построенных искусственно, так и созданных самой природой, подчиняется четырем основным физическим принципам.

Во-первых, во всех этих системах совершается периодическое движение.

Во-вторых, для поддержания этого движения необходим приток энергии от внешних источников, причем энергия должна поступать к системе отдельными порциями в строго определенные моменты времени. Для этого на пути от источника энергии к системе ставится "заслонка", а чтобы "угадать" момент, когда нужно открыть заслонку, используется цепь обратной связи.

В-третьих, общее количество энергии, поступающей в систему, должно в точности равняться количеству энергии, затрачиваемому системой. В противном случае движение либо постепенно прекратится, либо размах колебаний будет безгранично увеличиваться. Порции поступающей энергии "отмеряются" нелинейными элементами.

Наконец, в-четвертых, энергию в систему можно подавать непосредственно либо каким-нибудь косвенным образом, например изменяя значения одного из параметров.

Книгу "Автоколебания" можно назвать одной из наиболее кибернетических из всех написанных к тому времени книг. В ней идет речь об управлении в чистом виде, четко и в то же время чрезвычайно наглядно вскрываются механизмы управления, и нет никакой беды в том, что ни слова не говорится о тех же процессах в живых организмах. На том уровне, на котором ведется рассмотрение, ничего нового это все равно не принесло бы.

В начале 50-х годов Александр Александрович переехал в Москву и, объединив несколько разрозненных групп, создал и возглавил Институт проблем передачи информации Академии наук СССР, ставший тем центром, где появились первые ростки современной информатики в нашей стране. Он возглавлял этот институт вплоть до своей безвременной кончины в 1965 году.

После А. А. Харкевича и до настоящего времени Институт проблем передачи информации возглавляет член-корреспондент АН СССР В. И. Сифоров. Под руководством Владимира Ивановича Сифорова нам также пришлось поработать в 1944 году, но знакомство, к сожалению, ограничилось несколькими короткими встречами.

А. А. Харкевича мы вспомнили главным образом потому, что он практически был первым, кто усомнился в правомочности отождествления шенноновской меры количества информации и термодинамической энтропии. В своей книге "Очерки общей теории связи", представляющей собой одно из наиболее совершенных изложений на русском языке основ того, что тогда называлось теорией информации, он прямо указывает, что для отождествления шенноновской меры с энтропией нет достаточных оснований. В дальнейшем подобный взгляд получил ряд подтверждений.

Замкнутые теории

Вернемся снова к шенноновской теории. Мы и не заметили, как от рассмотрения совершенно конкретного понятия, а именно понятия количества информации перешли к более общим вопросам, связанным с возможностью применять ту или иную теорию в тех или иных обстоятельствах для описания тех или иных явлений. Подобные вопросы вообще характерны для современной науки. Лучший пример здесь - классическая, или ньютоновская, механика. В течение долгого времени она считалась образцом совершенной научной теории. Полагали, что все без исключения процессы в окружающем нас мире описываются в терминах ньютоновской механики и, зная начальные координаты и скорости всех объектов, составляющих Вселенную, с помощью уравнений ньютоновской механики можно предсказать состояние этих объектов, а значит, поведение всей Вселенной вперед на сколь угодно большой промежуток времени. Все это известно и несчетное количество раз повторялось как в научной, так и в научно-популярной литературе.

Общеизвестно также и другое. С появлением и утверждением теории относительности стало принятым мнение, что теория относительности дает более "правильное" описание мира, а ньютоновская механика представляет собой частный случай механики Эйнштейна, справедливый для случаев, когда скорости описываемых объектов во много раз меньше скорости света.

Однако первый удар механике Ньютона был нанесен задолго до появления теории относительности. Произошло это тогда, когда М. Фарадей высказал мысль о том, что существует группа явлений, для описания которых следует пользоваться понятием силового поля, отсутствующим в ньютоновской механике. После того как Дж. Максвелл облек идею Фарадея в строгую математическую форму, стало ясно, что ньютоновская механика не универсальна - существуют явления, которые описываются без ее привлечения.

Впоследствии некоторые естествоиспытатели и философы еще несколько десятилетий ожесточенно защищали позиции ньютоновской механики, опираясь на механическую модель эфира. Этот спор, как и многие другие мировоззренческие дискуссии, был даже перенесен на политическую арену. Но большинство физиков, опираясь на экспериментальные данные, признали правильными и специальную теорию относительности, и максвелловскую теорию. Ньютоновской теории отводилась роль хорошего приближения к правильной релятивистской механике.

Существует и иная точка зрения. Сторонник этой точки зрения немецкий ученый В. Гейзенберг - автор знаменитого соотношения неопределенностей. Предоставим ему слово:

"...Мы уже не говорим, что ньютоновская механика ложна и должна быть заменена правильной квантовой механикой. Скорее уж мы воспользуемся такой формулировкой: "Классическая механика является замкнутой научной теорией. Везде, где могут быть применены ее понятия, она дает в строгом смысле слова "правильное" описание природы". Мы, стало быть, и сегодня признаем истинность ньютоновской механики, даже ее строгость и общезначимость, но, добавляя, "везде, где могут быть применены ее понятия", мы указываем, что считаем область применимости ньютоновской теории ограниченной. Понятие "замкнутая научная теория" возникло впервые в такой форме в квантовой механике. В современной физике мы знаем, по сути дела, четыре крупные дисциплины, которые можем в таком смысле назвать замкнутыми теориями: помимо ньютоновской механики, это теория Максвелла вместе со специальной теорией относительности, затем учение о теплоте - со статистической механикой, наконец (нерелятивистская) квантовая механика вместе с атомной физикой и химией. Теперь следует несколько уточнить, какие особенности характеризуют "замкнутую теорию" и в чем может заключаться истинность такой теории".

Далее В. Гейзенберг формулирует критерии, которым должна отвечать научная теория, чтобы считаться замкнутой.

Первым критерием замкнутой теории является ее внутренняя непротиворечивость. С помощью специальных определений и аксиом она должна допускать столь точное определение понятий, первоначально почерпнутых из опыта, и устанавливать между ними столь строгие отношения, чтобы им можно было сопоставить соответствующие математические символы, связанные системой непротиворечивых уравнений.

Вместе с тем замкнутая теория должна быть в известном смысле изобразительной. Другими словами, понятия теории должны что-то означать в мире явлений. По мнению В. Гейзенберга, проблемы, связанные с этим требованием, до сих пор не получили достаточного освещения.

Эта мысль стоит того, чтобы остановиться на ней более подробно. В современной науке принято считать, что некоторая теория создана, если найдены математические уравнения и если с помощью этих уравнений можно получить числа и зависимости между числами, совпадающие с опытными данными. Но чем дальше мы идем по этому пути, тем меньше нам удается определить, что означает переменные, входящие в уравнения. В наибольшей степени это характерно для современной квантовой физики.

Следуя В. Гейзенбергу, замкнутая теория справедлива на все времена. Везде и всегда, в сколь угодно далеком будущем, если только опытные данные могут быть описаны в понятиях этой теории, ее законы окажутся правильными. Для ньютоновской физики исходными понятиями являются понятия массы, силы и ускорения. Соответственно для учения о теплоте, то есть термодинамики, исходными понятиями служат объем, давление, температура, энергия и энтропия.

Переход от одной замкнутой теории к другой, считает В. Гейзенберг, требует полного изменения структуры мышления тех, кто занимается развитием этих теорий. В частности, он отмечает, что даже А. Эйнштейн до конца своей жизни так и не смог признать правомерность вероятностных описаний и понятий, используемых в современной физике.

"Эйнштейн не хотел отвести столь принципиальную роль теории, имеющей статистический характер. Считая ее лучшим при данном состоянии знаний описанием атомных явлений, он все же не был готов принять ее в качестве окончательной формулировки законов природы. Фраза "но не думаете же вы, что Бог играет в кости" вновь и вновь произносилась им почти как упрек. По существу, различия между нашими двумя подходами лежали еще глубже. Эйнштейн в своих моделях физики всегда исходил из представления об объективном, существующем в пространстве и времени мире, который мы в качестве физиков наблюдаем, так сказать, лишь извне и движение которого определяется законами природы. В квантовой теории подобная идеализация уже невозможна; устанавливаемые ею законы природы говорят о временных изменениях возможного и вероятного; но условия, определяющие переход от возможности к факту, здесь не поддаются предсказанию: их можно зарегистрировать лишь статистически".

Ни в коей мере не претендуя на то, чтобы вмешаться в спор великих, мы позволим себе высказать собственное мнение и то лишь потому, что оно имеет непосредственное отношение к содержанию нашей книги. Речь пойдет вот о чем.

Описать некоторую физическую систему - что это означает с точки зрения ньютоновской физики? Это значит получить возможность для любого момента времени знать координаты и скорости составляющих систему компонентов. Говоря о координатах и скоростях, мы предполагаем существование не зависящих от описываемой системы пространства и времени. Согласно И. Ньютону, пространство (отсюда - координаты) и время есть та арена, на которой разыгрываются события во Вселенной.

Основным вкладом В. Гейзенберга в квантовую физику является его знаменитое соотношение неопределенностей, согласно которому мы не можем знать одновременно и точно и координаты и скорость объекта. В тех случаях, когда мы не можем знать что-то точно, современная наука предлагает нам единственный способ: описывать это "что-то" в терминах вероятностей. Попробуем рассуждать, следуя В. Гейзенбергу.

Согласно современным воззрениям (а это и есть та самая структура мышления, о которой говорит В. Гейзенберг) пространство и время не существуют независимо от материи. Наоборот, материальные объекты порождают пространство и время. Там, где нет материи, нет ни времени, ни пространства. Вот и получается заколдованный круг. Мы пытаемся описать поведение материальных объектов через то, что они порождают, что зависит от них самих.

Вместе с тем современная физика располагает рядом величин, таких, как электрический заряд, спин, лептонный заряд и тому подобное, которые могут быть известны совершенно точно и, следовательно, не требуют привлечения вероятностных подходов. Может быть, имеет смысл отказаться, естественно, там, где это существенно, от описания поведения объекта в терминах координат и скоростей?

Мы ни в коей мере не претендуем на высказывание каких-то советов физикам, и все сказанное имеет для нас отношение лишь к реальным возможностям получения информации о физических системах.

Существует ли камень?

Несколько слов о термодинамике - еще одной замкнутой, согласно классификации Гейзенберга, науке. Объектами изучения термодинамики являются системы, состоящие из очень большого числа компонентов: молекул или атомов. Мы уже говорили, что практически все законы термодинамики выводятся из двух основных: закона сохранения энергии и закона неубывания энтропии. Примечательнее всего то, что как при формулировке основных законов, так и при дальнейших выводах свойства самих компонентов системы, в данном случае молекул или атомов, практически не используются. Что требуется от молекул для того, чтобы состоящая из них система подчинялась законам термодинамики? Обладать некоторым запасом кинетической энергии и обмениваться этим запасом с другими молекулами в актах взаимодействия при условии, что сумма энергий всех молекул остается постоянной. Последнее условие и есть упомянутое условие того, чтобы система была замкнутой, то есть не обменивалась энергией с другими системами.

Существует ли камень?

Такими же свойствами обладают не только системы, состоящие из молекул и атомов, но и великое множество других систем, в том числе и полностью абстрактных. Например, множество чисел, для которых мы ввели условие, что они могут меняться как угодно, лишь бы сумма оставалась постоянной.

Отсюда с неизбежностью следует вывод, что закон неубывания энтропии - это не закон природы, а закон, описывающий поведение любой системы, в том числе и абстрактной, подчиняющейся только что сформулированному условию. Законом природы он становится тогда, когда имеются объекты, допускающие описание в понятиях термодинамики.

Законы термодинамики справедливы для песчинок, камней и целых планет. Но существует ли такой объект - камень? Наверное, для того чтобы ответить на этот вопрос, надо установить границы между тем, что мы считаем камнем, и тем, что мы камнем не считаем.

Вот это как раз невозможно. Камень и окружающий его воздух есть просто множество молекул; причем и в том и в другом случае расстояние если не между молекулами, то между ядрами атомов, из которых эти молекулы состоят, во много раз превышает размеры самих ядер.

Границы между камнем и не камнем есть результат некоторого вводимого нами условия. Отсюда вывод: камень - это не реальный физический объект, а понятие, которое мы условно вводим для того, чтобы получить возможность применять термодинамику. В этом нет ничего плохого или порочного. До тех пор пока нас интересует камень как таковой (то есть когда необходимые условия уже введены), мы можем знать с вполне достаточной для камня точностью все, что связано с его поведением. Но при этом не следует забывать о введенных условиях.

Все сказанное имеет прямое отношение и к закону неубывания энтропии. Этот закон далеко не так универсален, как представлялось тогда, когда на основании этого закона делались прогнозы о тепловой смерти Вселенной и неизбежного разрушения информации, то есть в конечном итоге гибели всего живого. Закон неубывания энтропии, безусловно, действует в рамках одной из научных дисциплин - термодинамики, которую благодаря В. Гейзенбергу мы считаем замкнутой дисциплиной, а следовательно, применимой к ограниченному кругу понятий. Закон неубывания энтропии не может быть применен к отдельным атомам и молекулам, которые обладают замечательным свойством сохранения своей структуры. Сколько ни разрушай молекулу воды, она восстанавливается, причем в точно таком же виде, что и до разрушения. Вряд ли у кого-нибудь могут быть сомнения в том, что именно молекулы и атомы, а не песчинки, камни и планеты составляют основу всего сущего.

Связь или информация?

Похоже, что мы снова отвлеклись от шенноновской теории. Нам давно пора вернуться к ней. Но прежде в порядке разминки или разрядки, как хотите, предоставим слово члену Национальной академии наук США Джону Р. Пирсу, известному своими работами по электронике сверхвысоких частот, радиолокации и связи:

"Насколько я могу судить, термины "общая теория связи" и "теория информации" являются синонимами. Я предпочитаю пользоваться первым термином, он мне кажется более определенным. Под тем или другим названием об общей теории связи было написано много всяких нелепостей, пожалуй, больше, чем о какой-либо иной технической области знаний после теории относительности и квантовой теории. Смысл слов "связь", "информация" и "теория" известен каждому. Услышав, что имеется теория о передаче любых сообщений, люди хотят как можно скорее применить эту теорию к решению своих проблем. А проблемы могут быть разные: в области философии, лингвистики, психиатрии, психологии, химии и физики. Применять всюду эту новую теорию, может быть, можно, а может, и нельзя".

Возможно, суждения Р. Пирса в чем-то чересчур резки, но и подобная резкость, и чрезмерные восторги, не раз высказывавшиеся по поводу шенноновской общей теории связи, имеют одну и ту же причину. Здесь постоянно делаются попытки перенести круг понятий одной замкнутой научной теории на другую - сделать то, от чего предостерегал В. Гейзенберг.

Шенноновская общая теория связи, к слову сказать, подобное название, за исключением слова "общая", было предложено самим К. Шенноном, в настоящее время представляет собой прекрасно разработанную и имеющую огромное количество практических применений теорию. Однако объектом приложения этой теории является отнюдь не информация, а каналы связи. Множество сигналов, распространяющихся в любом канале связи, будь то трансатлантический телеграфный кабель, телефонная или радиолиния, составляет статистический ансамбль, к которому применимы понятия статистической физики.

Задача, решаемая в рамках общей теории связи, всегда одна и та же: передать наибольшее количество сигналов с наименьшими затратами. В тех случаях, когда в канале связи присутствуют шумы, а присутствуют они всегда, решение подобной задачи часто приводит к поразительным результатам. В частности, удается выловить сигнал из смеси с шумами, во много раз превосходящими его по мощности. Но речь идет о сигналах, в частности об электрических токах и напряжениях, а не об информации.

Нам могут возразить, указывая на то, что средством общей теории связи решались такие задачи, как дешифровка закодированных текстов. Решались они именно потому, что с самого начала за основу принимался не смысл исходного сообщения, а известные статистические свойства языка, на котором это сообщение написано. Здесь полная аналогия с термодинамикой, где во внимание принимаются не свойства самих молекул и атомов, а лишь статистические свойства их множеств. Отсюда и знаменитое совпадение формализмов общей теории связи с формализмами термодинамики.

Введя несколько несущественных условий, мы действительно можем считать любой физический канал связи термодинамической системой со всеми вытекающими отсюда аналогиями. Мы можем считать даже шенноновскую общую теорию связи одним из разделов статистической физики. Но изучение свойств каналов связи ни в коей мере не означает одновременного изучения свойств информации, которая может передаваться по этому каналу, а может и не передаваться.

В заключение этой беседы мы вынуждены констатировать, что до сих пор мы не только не знаем, в каких единицах мерить количество информации, но и не знаем вообще, что такое информация.

|

ПОИСК:

|

© Злыгостев А.С., 2001-2019

При использовании материалов сайта активная ссылка обязательна:

http://informaticslib.ru/ 'Библиотека по информатике'

При использовании материалов сайта активная ссылка обязательна:

http://informaticslib.ru/ 'Библиотека по информатике'