7.4. Разбиение на классы слов посредством сетей

Сейчас мы рассмотрим альтернативный вариант процессора образов, предназначенный для обнаружения симметрий или S. Другими словами, будет осуществлена абдукция разбиения на классы слов, но теперь на основе идей о выводе с помощью сети, изложенных в гл. 6.

Допустим, что m = nT слов, υ = 1, 2,..., m представлены сенсорными векторами высокой размерности y1, y2, ..., ym∈Y = Rn. Векторы y можно рассматривать как стандартизированную форму представления речевых сигналов. Следуя афоризму де Соссюра о "произвольности знака", будем допускать очень хаотичное кодирование, а именно: множество векторов y порождается как независимо тождественно распределенная выборка из некоторого многомерного нормального распределения N (0, σ2I) с ограниченной общей мощностью, скажем, σ2 = 1/n.

Только некоторая часть сети  будет использоваться при проведении языковой абдукции, и лишь некоторое подмножество этой части -для обнаружения класса слов. Вполне может оказаться, однако, что другим частям сети

будет использоваться при проведении языковой абдукции, и лишь некоторое подмножество этой части -для обнаружения класса слов. Вполне может оказаться, однако, что другим частям сети  должна быть придана та же самая логическая архитектура. Действительно, в значительной мере цель нижеследующего построения -определить классы эквивалентности объектов, что может потребоваться при решении многих задач не лингвистического характера.

должна быть придана та же самая логическая архитектура. Действительно, в значительной мере цель нижеследующего построения -определить классы эквивалентности объектов, что может потребоваться при решении многих задач не лингвистического характера.

Результаты разд. 6.5 указывают, что при определенных условиях обучение будет иметь место и может быть описано с помощью некоторого оператора опыта Γ. Конкретный вид оператора Γ зависит от того, как представлены векторы y.

Слова встречаются в языке с вероятностями, которые мы вычислили в гл. 2, исходя из заданных параметров синтаксического поведения. Предполагается, что пары (υ, μ) слов порождаются в соответствии с этими вероятностями и одновременно предъявляются Ω, только если они эквивалентны. Нам известно, что в случае когерентного кодирования и равного внимания к x и y это означает представление (yυ + yμ)еυμ, причем eυμ, = 1, если υ ≡ μ, и eυμ = 0 в противном случае (см. предложение 6.2.10).

Это означает, что мы временно допускаем е = δ = 0, т. е. временно пренебрегаем обеими ошибками; к важному случаю неравенства нулю обеих ошибок мы вернемся после доказательства следующей теоремы.

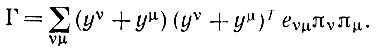

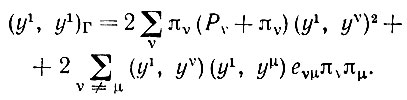

В таком случае оператор опыта Γ имеет вид (см. уравнение (6.2.44.))

(7.4.1)

(7.4.1)

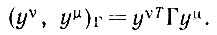

Нам известно, что yυ проявляют тенденцию к взаимной ортогональности и приблизительно имеют единичную длину (см. предложение 6.6.5). Этим можно воспользоваться для того, чтобы получить некоторое представление о внутреннем произведении, которое индуцируется изменением геометрии в результате обучения:

(7.4.2)

(7.4.2)Строгий вывод с учетом характеризующих ошибку членов требует проведения более тщательного асимптотического анализа. Силверстайн (1976) проделал эту работу, и мы приведем его вывод.

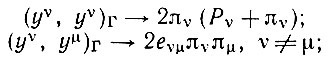

Теорема 7.4.1. При любых υ и μ справедливо

(7.4.3)

(7.4.3)здесь при n → ∞ имеет место сходимость по вероятности. Кроме того,

(7.4.4)

(7.4.4) и при υ ≠ μ

(7.4.5)

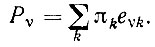

(7.4.5) Здесь Pυ - вероятность выбора слова из того же класса, что и υ:

(7.4.6)

(7.4.6)

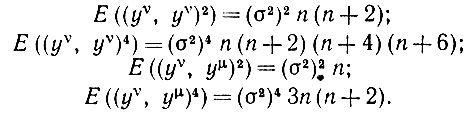

Доказательство. Нам потребуются математические ожидания внутренних произведений для измененной геометрии (yυ, yμ)Γ и их квадраты. В связи с этим появятся произведения, включающие два или четыре сомножителя. Непосредственное вычисление характеристической функции (yυ, yυ) (не модифицированная геометрия) дает (1 + z2)-n/2 при υ ≠ μ. Если υ = μ, то внутреннее произведение (yυ, yυ) представляет собой просто σ2, умноженную на некоторую χ2 - переменную с n степенями свободы. Это позволяет легко получить необходимые моменты, и при υ ≠ μ мы имеем

(7.4.7)

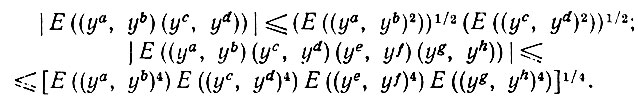

(7.4.7)С другой стороны, неравенство Шварца дает вполне очевидные границы:

Из (7.4.7) следует, что члены вида (7.4.8) будут стремиться к нулю при стремлении n к бесконечности, если одно из внутренних произведений связывает два различных вектора.

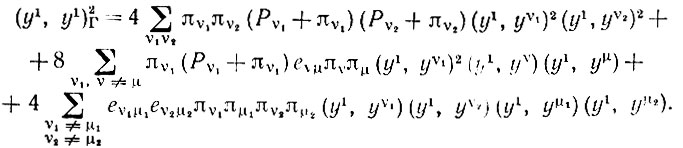

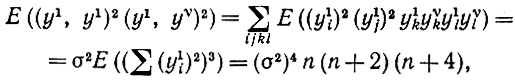

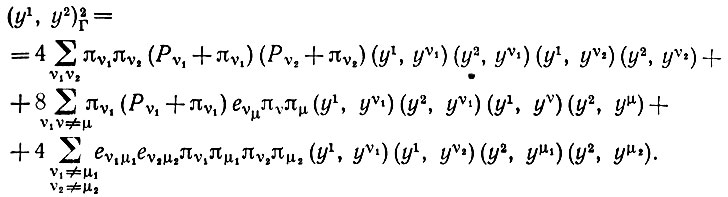

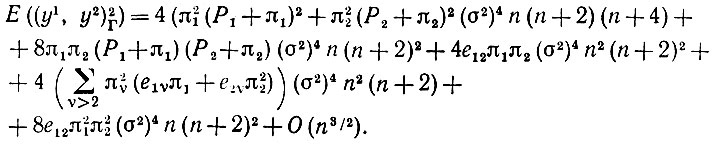

При доказательстве теоремы ничто не мешает выбрать υ = 1 и μ = 2. Для (y1, y1)Γ, введя новые индексы υ и μ при суммировании, получаем что

(7.4.8)

(7.4.8)Проводя дальнейшие упрощения, получаем следующее:

(7.4.10)

(7.4.10) Кроме того,

(7.4.11)

(7.4.11) Оба математических ожидания вторых сумм в (7.4.10) и (7.4.11) равны нулю, поскольку все члены этих сумм содержат нечетное число компонент одного вектора. Из (7.4.7) и (7.4.10) получаем следующее:

(7.4.12)

(7.4.12)и, следовательно,

(7.4.13)

(7.4.13)При υ ≠ 1 имеем

(7.4.14)

(7.4.14)поскольку третий момент случайной χ2-переменной с n степенями свободы равен n(n + 2)(n + 4).

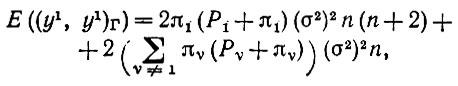

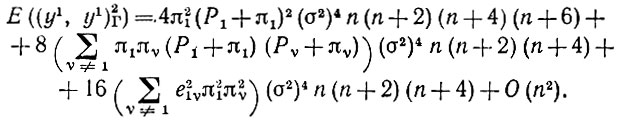

На основании (7.4.7), (7.4.11) и (7.4.14) получаем, что

(7.4.15)

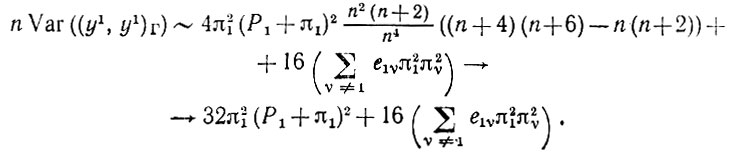

(7.4.15)Из (7.4.13) и (7.4.15) следует, что [Е ((y1, y1)Γ)]2 и Е((y1, y1)2Γ) стремятся к конечным и равным пределам. Таким образом, дисперсия (y1, y1) сходится к 0, что эквивалентно сходимости (y1, y1)Γ к 2π1(Р1 + π1) по вероятности. Кроме того,

(7.4.16)

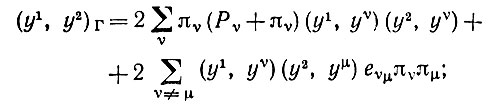

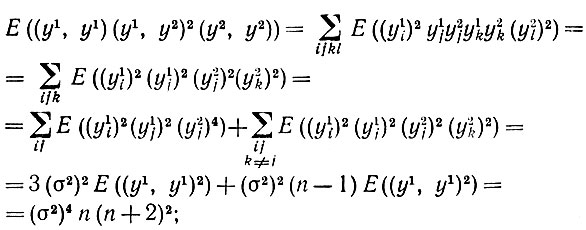

(7.4.16)Для (y1, y2)Γ мы аналогично получаем

(7.4.17)

(7.4.17) (7.4.18)

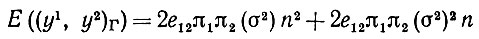

(7.4.18) Как и ранее, мы находим, что математические ожидания первой суммы в (7.4.17) и второй суммы в (7.4.18) равны нулю. На основании (7.4.7), (7.4.17) и того, что математическое ожидание величины, подчиняющейся распределению χ2 с n степенями свободы, равно n, получаем

(7.4.19)

(7.4.19) и

(7.4.20)

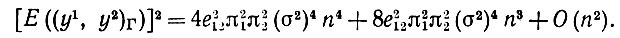

(7.4.20) Чтобы найти Е((y1, y2)2Γ), необходимо знать величину Е((y1, y1) (y1, y2)2 (y2, y2)). Мы имеем

(7.4.21)

(7.4.21)здесь использовано (7.4.7) и то обстоятельство, что четвертый момент случайной переменной, подчиняющейся N (0, σ2), равен 3(σ2).

На основании (7.4.7), (7.4.8), (7.4.14) и (7.4.18), получаем, что

(7.4.22)

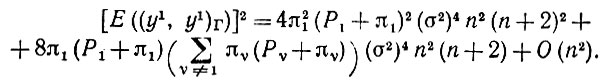

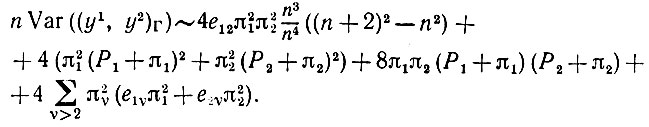

(7.4.22)Можно, следовательно, сделать вывод, что (y1, y2)Γ сходятся к 2е12π1π2 по вероятности и

(7.4.23)

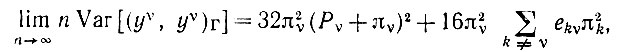

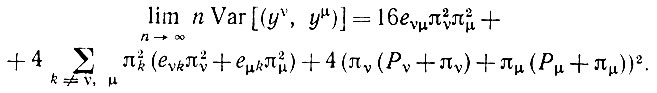

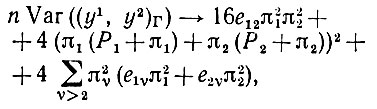

(7.4.23)Проводя дальнейшие упрощения, получаем, что при n → ∞

(7.4.24)

(7.4.24)

на чем доказательство заканчивается.

Из этой теоремы следует, что в результате обучение позволит существу Ω разделять слова υ и μ, если υ ≠ μ, поскольку сеть дает отрицательную реакцию: в пределе (yυ, yμ)Γ = 0. Если υ = μ но υ ≠ μ то в этом случае (yυ, yυ)Γ = 2πυ(Pυ + πυ) > 0, и, конечно, для идентичных слов (yυ, yυ)Γ = 2πυ(Pυ + πυ) > 0.

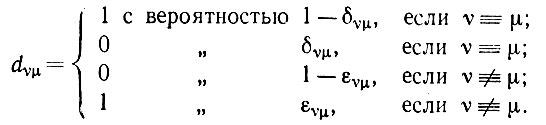

Допустим теперь, что ошибки ε и δ пренебрежимо малы. Тогда мы не станем утверждать, что (7.4.3) справедливо, но будем вынуждены вновь обратиться к (7.4.1), где eυμ следует теперь заменить на dυμ:

(7.4.25)

(7.4.25)

Рассматривая доказательство теоремы (7.4.1) с точки зрения непрерывности, можно убедиться, что (7.4.3) справедливо при небольших изменениях в правой части, если ευμ и δυμ достаточно малы.

Сопоставим этот результат с обсуждением, проведенным в конце предыдущего раздела. Там устойчивость имела место относительно ошибки ε, но не δ. Как только δ становится положительной независимо от того, насколько она мала, алгоритм "взрывается".

При алгоритме же, основанном на сети, малые ошибки не вызывают серьезных нарушений функций.

Итак, мы имеем возможность выбирать между довольно быстродействующим, но неустойчивым алгоритмом абдукции и устойчивым, но относительно медленным алгоритмом. Следует в то же время отметить, что второй алгоритм на самом деле окажется не медленнее первого, если при его реализации ориентироваться на параллельный режим работы, как это было бы в случае реальной "физической" сети.

|

ПОИСК:

|

© Злыгостев А.С., 2001-2019

При использовании материалов сайта активная ссылка обязательна:

http://informaticslib.ru/ 'Библиотека по информатике'

При использовании материалов сайта активная ссылка обязательна:

http://informaticslib.ru/ 'Библиотека по информатике'