§ 3.5. Синтез формальных нейронов с минимальным числом волокон на аналоговых ЭВМ

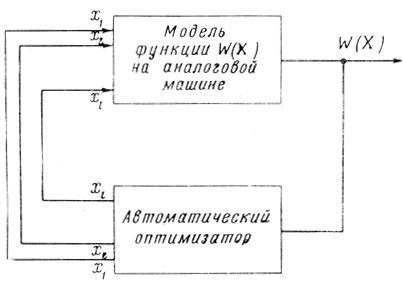

Синтез минимальных по числу волокон нейронов, основанный на поиске значений свободных переменных x̂j (j = 1,..., l), обеспечивающих минимальное значение Ŵ суммы всех волокон W, осуществлен также при помощи автоматической оптимизации на моделирующей установке ЭМУ-10.

Рис. 3.8

Моделирующая установка совместно с автоматическим оптимизатором (рис. 3.8) обеспечивают минимум функции W = W (х1,... ..., xj,..., xl), где l = n*2n-1 - 2n + 1, причем функция W и искомые значения x̂j, минимизирующие эту функцию, заранее не известны.

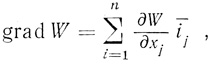

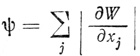

Оптимизатор автоматически подбирает величины х1,..., xl так, чтобы был достигнут минимум Ŵ функции W (X). Движение к минимуму происходит путем подсчета последовательно по всем переменным xj рабочих приращений, пропорциональных частным производным соответствующих переменных. По частным производным, полученным по всем переменным, находится вектор градиента

(3.77)

(3.77)где i-j - орты в пространстве х1,..., xj,..., xl (хi предполагаются декартовыми координатами). После определения градиента в данной точке делается шаг по направлению, противоположному направлению градиента, а затем в новой точке снова определяется градиент, делается следующий шаг и так далее. Таким образом, достигается наискорейшее уменьшение величины W (X), вплоть до получения Ŵ (X̂).

Общая идея автоматической оптимизации была изложена в работе [31].

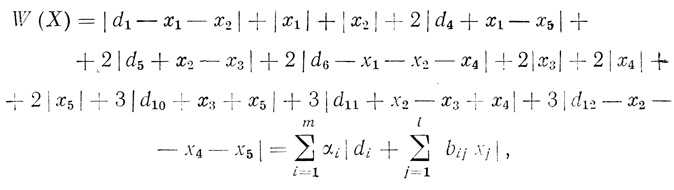

На рис. 3.9 показана принципиальная блок-схема автоматической минимизации W при помощи универсальной моделирующей установки ЭМУ-10 и автоматического оптимизатора*.

* (Схема разработана инженером Ю. А. Бортнюком.)

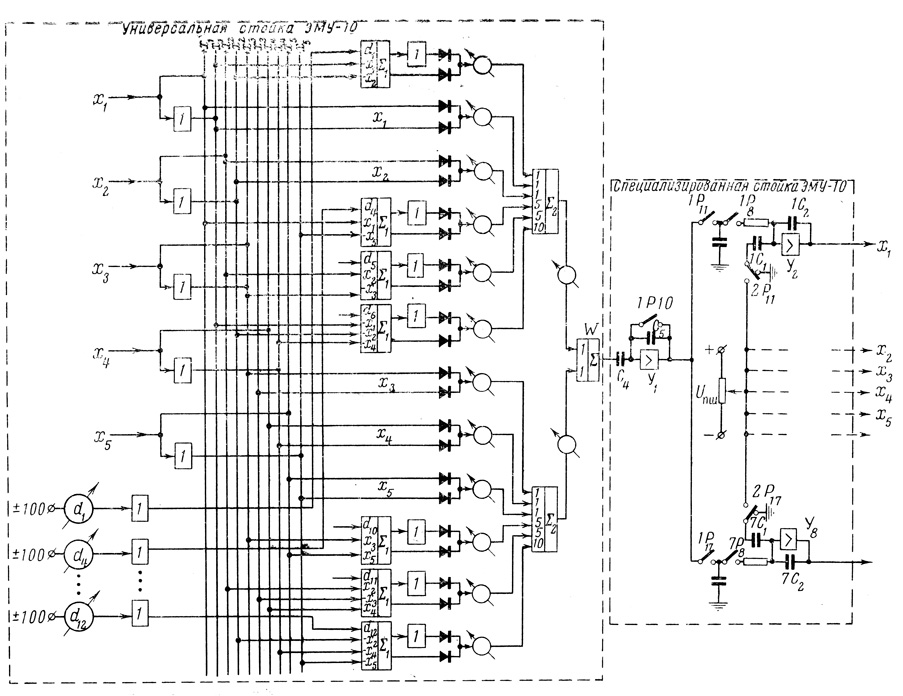

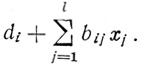

Синтез формальных нейронов с минимальным числом волокон производился для случая, когда n = 3 по ранее выведенной формуле:

(3.78)

(3.78)где m = n*2n-1; l = n*2n-1 - 2n + 1.

Рис. 3.9

Текущие (а в начале работы - произвольно установленные) значения xj из интеграторов (y2,......,y6) оптимизатора непосредственно поступают на универсальную стойку моделирующей установки, где отрабатывается модель по зависимости (3.78). Преобразователи (1) обращают те из xj, которые должны в соответствии с (3.78) иметь обратный знак.

Постоянные коэффициенты di для каждой конкретной диаграммы, заданной для реализации в виде нейрона с минимальным числом волокон, набираются на потенциометрах. Коэффициенты di и переменные величины хj и - хi подаются на усилители для получения алгебраических сумм ∑1 слагаемых формулы (3.78). После этого диодные схемы выделяют модули полученных на усилителях Σ1 сумм вида

Величины аi представляются в виде масштабных коэффициентов.

Полученные модули суммируются затем усилителями Σ2 и Σ3, в результате чего на выходе последнего усилителя получается текущее значение функции W (X). Функция W (X), полученная на модели в виде напряжения, подается на стойку автоматического оптимизатора.

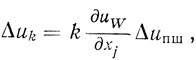

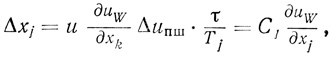

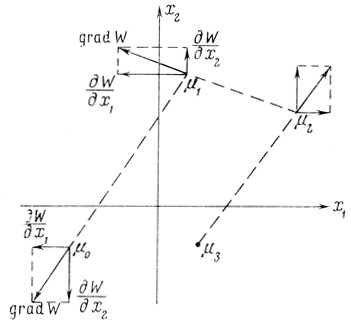

Автоматический оптимизатор представляет собой самонастраивающуюся систему, обеспечивающую автоматический поиск условий, при которых функция W нескольких переменных хj может иметь минимум. Движение к экстремальной точке происходит путем подачи одновременно по всем переменным рабочих приращений, пропорциональных частным производным соответствующих переменных. Работа оптимизатора происходит циклами. В каждом цикле проводятся пробные шаги, которые состоят в последовательной даче приращений Δхj по каждой из переменных отдельно и в определении составляющих dW/dx,- градиента grad W в некоторой начальной точке М0. В конце каждого цикла (т. е. после последовательного определения всех dW/dxj) производится рабочий шаг, который происходит по направлению, противоположному направлению градиента. При этом переменные хj получают дискретное приращение

Δxi = k (dW/dxj), (3.79)

где k = const > 0.

В новой точке (обозначим ее через М1) для всех xj производится новый цикл пробных шагов, снова определяется градиент, после чего производится новый рабочий шаг по направлению, противоположному направлению вновь найденного градиента, и т. д.

Так продолжается до тех пор,, пока величина

окажется меньше некоторой заранее заданной малой постоянной ψ1. При этом величина W достигает минимального значения Ŵ, а поступающие с интеграторов (y1,.....,y8) оптимизатора величины хj являются в этом случае оптимальными значениями x̂j, по которым может быть построен формальный нейрон с минимальным числом волокон (см. § 3.4).

Длительность каждого шага определяется величиной k из (3.79); при малом значении k осуществляется точный поиск минимума, при больших значениях k - грубый. Вначале осуществляется грубый поиск, который позволяет приближенно отыскать место минимума, а затем система переводится на малый шаг и место минимума находится более точно. Рассмотрим несколько подробнее работу схемы рис. 3.9. Начальное значение переменных выставляется на усилителях y2,......,y6 оптимизатора произвольным образом. В том случае, когда на вход усилителей не подается напряжение, на их выходах сохраняется то напряжение, которое имело место в момент отключения входов.

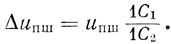

Определение частных производных осуществляется следующим образом. При значениях xj0, представляемых в оптимизаторе напряжениями, производится запоминание экстремизируемой функции W0. ДЛЯ этого замыкается контакт 1 Р10 и на выходе усилителя y1 устанавливается напряжение, равное нулю. Конденсатор С4 заряжается до напряжения uw, соответствующего значению функции W в точке (х10, x20,...,xl0). Затем контакт 1 Р10 размыкается и срабатывает реле Р11. Это реле своим контактом 2 Р11 изменяет напряжение на конденсаторе 1 С1 на величину Uпш (напряжение пробного шага). При этом на выходе усилителя y2 происходит изменение напряжения на величину

Напряжение на выходе усилителя y2 представляет переменную х1, следовательно, в момент срабатывания реле Р11 подается пробное приращение Δuпш по первой переменной. При поступлении на конденсатор С4 нового значения напряжения, соответствующего функции W (х10 + Δuпш, x20,..., хl0), на выходе усилителя y1 выделяется разность

Δu1 = [uW(x10, x20,....,xl0)-uw(x10+Δuпш, x20,.....,xl0)]C4/C5

В оптимизаторе принято отношение С4/С5 = k = 10, т. е. происходит усиление приращения функции в 10 раз.

Конденсатор 1 С3 через контакт 1 Р11 подключается к выходу усилителя ух и заряжается до напряжения Δu1. Ввиду постоянства и небольшой величины Δuпш напряжение Δuпш = dW/dx1. Аналогично происходит операция определения частных производных по другим переменным xj.

После того как все запоминающие конденсаторы заряжены до напряжения

производится рабочий шаг, который делается по направлению, противоположному направлению градиента. Для этого входы интеграторов y1,..., yl через контакты 1 Р8, ..., l Р8 присоединяются к соответствующим конденсаторам, и на выходе интеграторов получается приращение напряжения

где τ - длительность рабочего шага, a Tj - постоянная времени интеграторов. Напряжение на запоминающем конденсаторе во время рабочего шага уменьшается, однако это изменение мало, так как постоянная времени разряда в 10 раз больше постоянной времени интеграторов.

Получив дискретные приращения Δxj, переменные хj перемещают значения функции W из начальной точки М0 в новую точку М1 (на рис. 3.10 показан случай двух переменных: х1 и х2). В но вой точке производится следующий цикл, т. е. запоминается изменившееся значение функции W, определяются ее частные производные и осуществляется рабочий шаг по направлению, противоположному направлению градиента. Циклы повторяются, как уже отмечалось, до тех пор, пока величина φ = jΣ|dW/dxj| окажется меньше некоторой достаточно малой постоянной ψ1 причем W достигает минимального значения Ŵ, а обеспечивающие его х̂j считываются в качестве искомых.

Рис. 3.10

Точность поиска экстремума значения функции W может регулироваться величиной τ, а также величиной пробного шага Δuпш. В зависимости от них можно осуществлять грубый и точный поиск значения экстремума функции W (X).

Автоматический оптимизатор может работать как по методу градиента, так и по методу быстрого спуска. При этом если приращение функции W (X) имеет нужный знак и превосходит некоторое заданное значение ΔWH то рабочий шаг по прежнему градиенту повторяется. Если ΔW < ΔWH, то происходит определение нового градиента. Таким образом, метод быстрого спуска используется вдали от экстремума, когда производные велики, а затем происходит переход на метод градиента, т. е. определение градиента после каждого рабочего шага, вблизи от экстремума, где производные функции малы.

После проверки значения приращения функции происходит запоминание нового значения функции, для чего замыкается контакт 1 Р10 и происходит или повторение рабочего шага, или определение нового градиента.

В оптимизаторе также предусмотрено введение ограничений, накладываемых на координаты исследуемого объекта. Время решения одной задачи в зависимости от масштаба пробных шагов и характера поведения функции W (X) колеблется от 5 до 20 мин.

Величины х̂j считываются с цифрового оптического индикатора с достаточно большой точностью (до десятых долей вольта). При решении одной и той же задачи (т. е. при фиксированном наборе di), но с различными начальными значениями х̂j(0) можно получить несколько различных наборов х̂j(1),...,х̂j(k) обеспечивающих минимальное число волокон Ŵ. Факт многозначности решения задачи синтеза нейронов с минимальным числом волокон впервые был обнаружен при работе с моделирующей установкой и автоматическим оптимизатором по изложенной методике.

Помимо синтеза обычного трехвходового формального нейрона, на установке был также осуществлен синтез трехвходовых нейронов с использованием волокон типа "запрет запрета". Для этого на универсальной стойке была набрана модель, соответствующая формуле (3.29), которая содержит 11 переменных. В связи с этим пришлось использовать две стойки автоматических оптимизаторов (так как одна стойка обеспечивает оптимизацию по 7 переменным). Для синтеза четырехвходовых нейронов пришлось бы использовать уже три оптимизатора. Рост необходимого оборудования с увеличением n и сравнительно большое машинное время, потребное для решения одной задачи, являются главными недостатками описанного метода. Вместе с тем он дает вполне удовлетворительные результаты и при невозможности использования ЭЦВМ может быть применен для синтеза формальных нейронов с минимальным числом волокон Ŵ. Результаты, полученные методом автоматической оптимизации на моделирующей установке, совпали с результатами решения тех же задач методом линейного программирования на ЭЦВМ.

|

ПОИСК:

|

© Злыгостев А.С., 2001-2019

При использовании материалов сайта активная ссылка обязательна:

http://informaticslib.ru/ 'Библиотека по информатике'

При использовании материалов сайта активная ссылка обязательна:

http://informaticslib.ru/ 'Библиотека по информатике'